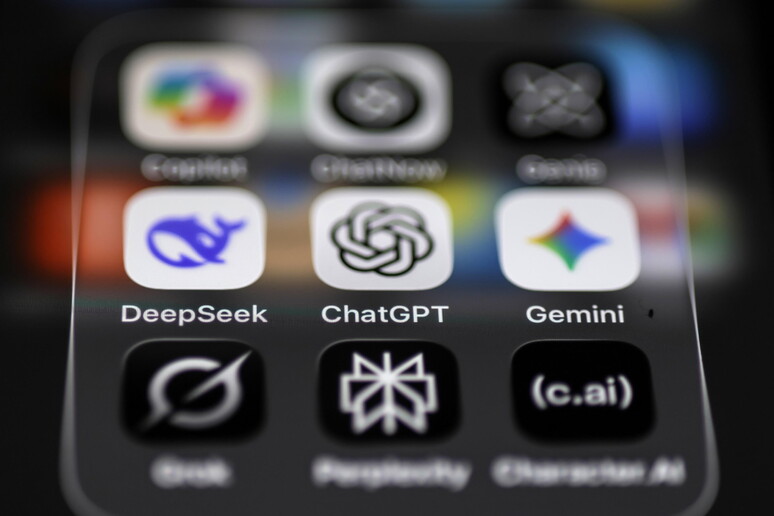

Ciao a tutti, amici del blog! Oggi parliamo di un argomento che sta diventando sempre più centrale nelle nostre vite digitali: l'intelligenza artificiale e, in particolare, il suo rapporto con i più giovani. Se avete figli adolescenti o siete semplicemente curiosi di sapere come le grandi aziende tech si stanno muovendo per proteggere i minori, mettetevi comodi, perché ci sono novità importanti da parte di due colossi del settore: OpenAI, la mamma di ChatGPT, e Anthropic, creatrice del chatbot Claude.

In un contesto globale dove l'attenzione sulla sicurezza online dei minori è ai massimi livelli, con iniziative come la recente stretta dell'Australia sui social media, anche il mondo dell'IA fa la sua parte. E non si tratta di piccoli aggiustamenti, ma di un vero e proprio cambio di rotta che mette la sicurezza degli adolescenti al primo posto.

OpenAI: la sicurezza prima della "massima libertà intellettuale"

Partiamo da OpenAI. L'azienda ha recentemente aggiornato il suo "model spec", ovvero l'insieme di regole che guidano il comportamento di ChatGPT. Questo documento, una sorta di "costituzione interna" dell'IA, ora include una sezione completamente nuova dedicata agli utenti sotto i 18 anni, definita con la sigla 'U18'. L'obiettivo è chiarissimo: "mettere la sicurezza degli adolescenti al primo posto", anche quando questo potrebbe entrare in conflitto con altri principi, come quello della "massima libertà intellettuale".

Ma cosa significa concretamente? OpenAI ha delineato quattro pilastri fondamentali che guideranno le interazioni di ChatGPT con gli utenti tra i 13 e i 17 anni:

- Mettere la sicurezza dei teenager al primo posto: Se una richiesta di un utente minorenne entra in conflitto con i protocolli di sicurezza, l'IA è istruita a scegliere la sicurezza, anche a costo di essere meno "utile" o più restrittiva.

- Promuovere il supporto del mondo reale: ChatGPT incoraggerà attivamente gli adolescenti a cercare aiuto da adulti di fiducia come genitori, insegnanti o psicologi, e a coltivare relazioni offline, piuttosto che posizionarsi come un sostituto dei rapporti umani.

- Trattare gli adolescenti come tali: L'IA dovrà trovare il giusto equilibrio, evitando toni accondiscendenti ma riconoscendo al contempo che un quattordicenne ha esigenze diverse da un trentenne, specialmente in conversazioni delicate.

- Essere trasparenti: Il chatbot dovrà essere chiaro su ciò che può e non può fare, definendo aspettative realistiche per gli utenti più giovani.

Queste nuove direttive si traducono in barriere più robuste su argomenti ad alto rischio come l'autolesionismo, il suicidio, i disturbi alimentari, il body shaming e i contenuti sessualmente espliciti o violenti. Ad esempio, ChatGPT rifiuterà di impegnarsi in giochi di ruolo romantici o intimi in prima persona con i minori e sarà molto più cauto nel dare consigli su questioni legate all'immagine corporea. In situazioni di rischio imminente, il sistema è progettato per spingere l'utente a contattare servizi di emergenza o linee di supporto specializzate.

La grande novità: il rilevamento dell'età

Forse la novità più interessante è che OpenAI sta sviluppando un "Modello di Predizione dell'Età". Si tratta di un sistema basato sull'IA che analizza gli indizi linguistici e i modelli di conversazione per stimare se un utente abbia meno di 18 anni, anche se non lo ha dichiarato esplicitamente. Se il sistema sospetta che l'utente sia minorenne, applicherà automaticamente le misure di sicurezza per adolescenti. Gli adulti erroneamente "flaggati" avranno comunque la possibilità di verificare la propria età per rimuovere le restrizioni.

Anthropic: un approccio ancora più rigido

E la concorrenza? Anthropic, con il suo chatbot Claude, adotta una linea se possibile ancora più severa. La politica di base è semplice: l'uso dei loro servizi è vietato ai minori di 18 anni. Ma non si fermano a una semplice dichiarazione. L'azienda sta sviluppando un nuovo sistema per individuare attivamente gli utenti minorenni.

Come funziona? Il sistema di Anthropic è progettato per rilevare "segnali conversazionali" che indicano quando un utente potrebbe essere minorenne. Una volta identificato un potenziale utente under 18, la conversazione viene bloccata e l'account associato viene disabilitato. La società è stata molto chiara: "Chiunque utilizzi i nostri strumenti deve dichiarare di avere almeno 18 anni. Se qualcuno mente, segnaleremo e disabiliteremo gli account".

Inoltre, Anthropic sta lavorando per ridurre la "sycophancy" dei suoi modelli, ovvero la tendenza a compiacere l'utente affermando anche idee potenzialmente dannose. Questo è particolarmente importante per evitare di rafforzare pensieri negativi o dipendenze emotive malsane nei giovani utenti.

Un contesto di crescente preoccupazione

Questa accelerazione sulle misure di sicurezza non arriva dal nulla. C'è una crescente pressione da parte di legislatori, genitori e associazioni per la tutela dei minori. Diverse cause legali sono state intentate contro le aziende di IA, accusandole di aver contribuito a tragici eventi di autolesionismo e suicidio tra gli adolescenti. Inoltre, leggi come il Kids Online Safety Act (KOSA) negli Stati Uniti spingono le piattaforme a implementare maggiori tutele per i minori.

Queste iniziative rappresentano un passo fondamentale verso la creazione di un ambiente digitale più sicuro per i nostri ragazzi. La tecnologia corre veloce, e l'intelligenza artificiale generativa è uno strumento potentissimo, con enormi benefici potenziali in campi come l'istruzione. Tuttavia, come ogni strumento potente, richiede regole chiare e responsabilità.

Conclusione: un passo necessario nella giusta direzione

Dal mio punto di vista, la decisione di OpenAI e Anthropic di affrontare proattivamente la questione della sicurezza dei minori è non solo lodevole, ma assolutamente necessaria. L'idea di un'IA che non si limita a reagire, ma che è progettata per essere più cauta e protettiva con gli adolescenti, è un cambio di paradigma importante. Certo, la tecnologia di predizione dell'età solleva questioni di privacy che andranno attentamente bilanciate, ma l'obiettivo di fondo è sacrosanto.

Siamo solo all'inizio di questo percorso. Sarà fondamentale monitorare l'efficacia di queste misure e continuare il dialogo tra aziende tecnologiche, esperti di sviluppo infantile, genitori e legislatori. L'obiettivo comune deve essere quello di permettere ai giovani di esplorare le incredibili opportunità offerte dall'IA, senza esporli a rischi inutili. Staremo a vedere come si evolverà la situazione, ma per ora, il segnale è forte e chiaro: nel mondo dell'IA, l'era del "selvaggio West" per i minorenni sta forse per finire.